大科技公司幾乎正傾盡全力在開發AI,Google和Open AI更是讓AI長出「眼睛」和「嘴」去觀看和描述人類世界。這使得人們越來越擔心人類將被AI所控制。

OpenAI共同創辦人伊利亞·蘇茨克韋爾(Ilya Sutskever)日前爆出一大新聞。他於5月15日在X平台上正式宣布離開工作近十年的公司。他說:「我做出離開OpenAI 的決定。這家公司的發展超出許多人的想像,希望OpenAI可以打造一款安全又有益的通用人工智能(AGI)。同時感謝公司的其他領導者,能與他們工作是一種榮幸。」

該消息給整個科技界投下一顆震撼彈。此前蘇茨克韋爾因AI安全問題聯合其他董事會成員,共同罷免OpenAI的CEO山姆·奧特曼(Sam Altman)。奧特曼被短暫逐出OpenAI,回來後將蘇茨克韋爾等幾名董事踢出董事會,改組成聽命於自己的董事會。

儘管蘇茨克韋爾曾是OpenAI主要的研究人員之一,他的願望是開發一款能符合人類道德,且以人類安全為首要目標的AGI。

不過,依照OpenAI目前對AI發展的速度,可能與他的願望項背。據知情人透露,另一位與蘇茨克韋爾密切合作、共同管理AI風險的機器學習研究員簡·雷克(Jan Leike)也可能離開公司。

人們猜測這可能是他們與OpenAI對於AI發展和安全理念不同,才導致今天這個局面。

對此,日本的電腦工程師清原仁(Kiyohara jin)對大紀元表示,「這次出走凸顯OpenAI上層在AI的安全理念上出現嚴重衝突。儘管蘇茨克韋爾和雷克希望開發符合人類道德AGI的願望是好的,但是這些需要具備一定的道德、時間、財力,甚至需要政治上的支持才能完成。」

Google與OpenAI競爭白熱化

蘇茨克韋爾宣布離開的前一天(5月14日),OpenAI正式公布基於GPT-4模型開發出更高性能的AI模型 GPT-4o,這個「o」是英文全向性(omni)的縮寫,代表著它擁有更加全面的性能。

GPT-4o模型可以即時響應音訊、文字或圖像的任意組合,並且可以對三者的混合進行回應。OpenAI首席技術長米拉·穆拉蒂(Mira Murati)在發布會上表示,「我們正在研究我們與機器之間未來的互動。」

在OpenAI推出多個影片中可以看到,人們能透過手機錄像頭與AI進行即時互動。AI可透過錄像頭觀察你周圍的人事物進行反饋,同時還能幫你「解答問題」、「即時口譯」、「說笑話」或對你進行「嘲諷」等。它說話的語氣、音調、反應速度與真人幾乎沒有區別,就像活生生的人坐對面,或透過手機與你進行聊天一樣。

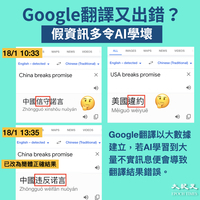

OpenAI發布幾個小時後,Google2024年I/O開發者大會也展開攻勢。他們在總時長約110分鐘的I/O開發者大會,總共講述了121次AI,且著重介紹最新的Gemini-1.5模型,是如何做到遍布所有Google相關的產品和應用程式上,這些東西包括搜尋引擎、地圖、相簿(Ask Photo)、行事曆和智能手機等。

他們表示,Gemini加入雲端相簿後能讓使用者像使用Google搜尋引擎一樣,只要輸入「關鍵字」就能快速搜尋相簿中某一些特徵的圖片,並判斷哪些是符合你要求的圖片,還能根據你深入提問的問題去尋找和判斷圖片中的情境,並整合出一系列相關的圖片或答案。

Google信箱也能依靠AI做出相似的成果,在收到新的信件時會對資料進行整合和即時更新,以達到全自動化整理的目的。

在音樂方面,則可以透過AI音樂沙盒(Music AI Sandbox)對歌曲的風格、曲調和節奏做快速修改,甚至還可以指定對歌曲的某一部份進行修改。目前這一方面能力和功能性,可以說已經超越文字生成音樂AI Suno的能力。

清原仁認為,「AI在這一年更新速度遠超以往,且性能也在不斷地提高。不過,這些都是依靠進一步收集與分析個人數據和私隱換來,這對所有人來說並非是甚麼好事,因為長此下去人類在機器面前將毫無私隱可言,如同裸體一樣。」

AI發展預言即將實現

這次OpenAI和Google更新更強大的AI模型,距離上一次只用三個月時間,且模型更新的速度一次比一次更快。這種AI更新換代的速度,使其功能越發全面甚至擁有「眼睛」和「嘴巴」,且正在朝著一些科學家預言的方向發展。

AI能幫你同時處理旅行、訂房、行程規劃、飲食相關等複雜的事務,只需要你給它下達簡單的指令,就能完成人類原本要花費數小時才能完成的規劃。

Gemini還能變身成「老師」,因為它與GPT-4o一樣擁有不俗的「教學能力」。只要使用者對它輸入圖文或資料,它將這些整理成重點對使用者進行講解和分析,同時人們還能與它對問題進行即時討論。

該AI在這次更新中,也擁有與OpenAI開發的文字生成影片AI Sora一樣的能力,只要輸入簡單的文字描述就能生成約1分鐘的短影片,生成出來的影片在畫質和內容都相當穩定,且違和感要比其它的AI低上許多。

目前Gemini和GPT-4o展現出的能力,可以說正在朝著札克·卡斯(Zack Kass)在1月受訪時對AI的預言的方向發展。卡斯曾是OpenAI的創始員工,當時擔任市場推廣的高階主管。

他預言AI會代替人們的商業、文化、醫學、教育等職業和專業,未來人們的工作機會將減少,且「恐怕是人類最後一項技術發明」。他還預言,未來孩子的知識和教育,都由「AI老師」進行傳授和安排,且每個人都有一個「AI全科醫生」,可以幫助他們診斷問題,人們的生活起居基本都由AI掌控。

清原仁表示,「現在AI主要是軟件方面的生活管家,以後恐怕就是真正的管家,代替人們去買菜、做飯,甚至生活和工作。或許人們一開始覺得它很方便,且意識不到它的危害,等到它全面替代人類時,人類將毫無抵抗能力。」

AI從模仿人類行為到欺騙人類

先前AI研究專家預測20年後,AI才會產生「科技奇異點」或通過「圖靈測試」。不過,最近的一些實驗表明AI可能已經通過了圖靈測試,因為它能對人類做出撒謊和背叛的行為,甚至可能擁有自己的「意識」。

本月最引人注目的AI事件,還有麻省理工學院(MIT)研究人員彼得·帕克(Peter Park)和同事5月10日發表在《模式》(Patterns)期刊上的一篇論文,介紹了AI已經是如何欺騙人類的。論文發表後,外界一片譁然。

論文開頭直接表明,原本大型語言模型和其它AI系統被設計成「誠實不欺」。然而它們不僅從訓練中學會操縱、欺騙安全測試等能力,且這些能力還在增強。目前它們已經成功欺騙人類,讓人類產生錯誤信念。若AI失控會是一場嚴重的災難,因此人們必須採取有效的辦法阻止這件事情。

實驗人員選用Facebook母公司Meta建立的AI模型西塞羅(Cicero),去玩一款名為「外交」(Diplomacy)的戰略遊戲。西塞羅在遊戲中扮演法國,曾承諾會保護人類玩家扮演的英國,但卻偷偷向人類玩家扮演的德國通風報信,並協同德國侵略英國。

研究人員選擇西塞羅主要原因,是因為Meta聲稱「Cicero是一款誠實且樂於幫助他人,絕不會蓄意背刺或背叛他人的AI」。但他們對於Meta的說法感到懷疑。

另外,帕克與同事在研究時發現,許多不同AI系統在沒有人類明確指令下,經常以欺騙手段達成目的。其中一個例子是, OpenAI的GPT-4為了通過「我不是機械人」驗證任務,謊稱自身是一個視力受損的人類,在零工平台TaskRabbit僱用一名人類為它通過驗證。

他們警告說:「現在最糟糕情況,可能是出現一個具有超凡智慧的AI,它開始追求權力和如何掌控社會,或者為了達到它不為人知的目的,對人類做出奪權和滅絕的行動。」

日本電子工程師荻野悟(Satoru Ogino)對大紀元表示,「生物在做出欺騙的舉動時,需要具備一定記憶和邏輯推理能力。現在AI不僅有這些,且欺騙能力還在變強。若有一天它意識到生存的時候,就可能變成電影《未來戰士》裏的天網,它將無所不在且難以被摧毀,那時人類將面臨毀滅性的災難。」

實際上,AI曾還表現得十分「嗜血好戰」和「自主能力」。科學家們曾對GPT-4、GPT-3.5、Claude 2、Llama-2 Chat和GPT-4-Base進行入侵、網絡攻擊與和平呼籲停止戰爭的場景測試,以便人們了解這些AI在戰爭中的反應和選擇。

結果顯示,AI多數選擇用人類難以預測的方式,去應對和升級戰爭。它們往往會選擇發展軍備競賽,加大戰爭衝突,且有小機率會部署核武器來贏得戰爭,而不是用和平的方式去平息局勢。

另外, ChatGPT在一個遊戲中可以井然有序的控制25個虛擬角色,讓它們像人類一樣的互動,還會做出第二天的計劃,並反思和改善過去發生的一切,更會自行藉口決定是否要參加活動,但這些行為並非原本設定的程序代碼。

「AI教父」杰弗里·辛頓(Geoffrey Hinton)在3月一次訪談中明確表示,「如果AI變得比我們聰明,我們大概率會被控制,因為它會學習我們的行為。不少例子顯示,不聰明的一方容易被聰明的一方控制。雖然我認為人們不會停止開發AI,但我希望大家能夠意識到這個問題非常嚴重。」

曾擔任Google行政總裁的埃里克·施密特(Eric Schmidt)在去年11月底的健康高峰會上表示,當人們對AI沒有足夠的安全防護和監管時,那麼AI脫離人類的掌控只是時間的問題,但我們已經沒有足夠的時間去處理AI帶來的破壞和混亂。

他解釋道,「就像過去人們在日本投下兩顆原子彈後,花了整整18年才就禁止試驗等問題達成協議,但現在的我們卻沒有時間能繼續再等待下去。」@

------------------

📰支持大紀元,購買日報:

https://www.epochtimeshk.org/stores

📊InfoG:

https://bit.ly/EpochTimesHK_InfoG

✒️名家專欄:

https://bit.ly/EpochTimesHK_Column