導語:AI 並不只是技術,它正在把治理、審查、恐懼與風險「系統化」。在一個缺乏制衡的結構裏,算法不是中立工具,而是權力的延伸。

中國進入 AI 時代,並不只是一次技術升級,而是一場政治治理方式的深度變形。在中國語境中,AI 並非中立工具,它更像是一種被高度政治化的「權力技術」,被嵌入到維穩、治理、意識形態與社會控制的核心結構之中。

一、AI 在中國首先不是「創新工具」 而是「治理工具」

在許多國家,人工智能更多被置於「技術進步」與「經濟發展」的討論框架之中,被視為提高生產力、優化商業效率或改善公共服務的中性工具。然而在中國,AI 的發展路徑從一開始就呈現出明顯不同的政治取向。它最早、也最系統化的應用場景,並不在市場競爭或社會福祉領域,而是在治理、維穩與社會控制之中。

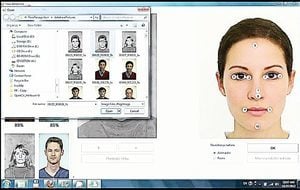

從人臉識別、行為識別到軌跡追蹤,從大數據建模到風險評分系統,AI 被迅速嵌入公共安全、城市治理和社會管理體系之中。通過對個體行為、社交關係和日常活動的持續採集與分析,技術被用來預測所謂的「潛在不穩定人群」,並提前介入可能被視為風險的社會行為。輿情監測、情緒分析與風險預警系統,則進一步將公共表達轉化為可量化、可排序、可處置的數據對象。

關鍵在於,這些技術並非在一個自由、開放的環境中被「誤用」或「濫用」,而是在高度明確的政治目標指引下被設計、部署並不斷優化的。在中國的制度語境中,AI 並不是為了限制權力運行,而是為了讓權力運行得更高效、更低成本、更難被質疑。算法的引入,使得原本依賴大量人力的監控與干預過程,轉變為可以長期自動運轉的系統工程。

這種技術路徑帶來的變化並不僅是規模上的擴大,更是性質上的轉變。AI 讓權力變得更加「精細化」:不再依賴粗放式的全面壓制,而是針對個體、群體和行為模式進行差異化管理;讓權力更加「自動化」:監控與篩選不再需要持續的人工判斷,而是由系統自行完成;同時也讓權力顯得「去情緒化」:壓制不再以明確的命令或懲罰出現,而是以系統判斷、風險提示和技術合規的形式展開。

因此,理解中國 AI 的政治意義,不能把它視為一種外來技術對政治結構的衝擊。恰恰相反,AI 的發展方向本身,正是由既有的政治邏輯所塑造和引導的。

AI 不是改變中國政治的外力,而是中國政治主動選擇、並不斷塑造的權力工具。

二、算法讓權力從「人治」升級為「系統治」

傳統高壓政治存在一個長期難以克服的內在缺陷:它高度依賴具體的人來執行。無論制度設計多麼嚴密,權力的運作終究要通過官員、警察和基層執行者來完成。而人本身並不穩定——官員會懶惰,警察會犯錯,執行者會猶豫、會同情、會權衡風險,也會因為責任壓力而選擇「不作為」。

AI 的出現,恰好彌補了這一缺陷。算法不需要政治動機,不會情緒波動,也不存在良心或同情心。它不需要理解行為的社會背景,只需要數據、閾值和指令。只要規則被設定,系統就可以在沒有任何道德負擔的情況下持續運行。

正是在這一點上,政治控制開始呈現出一種全新的形態。權力不再主要依賴事後的懲罰機制,而是通過預測與干預,提前介入個體行為的可能性空間。監控的重點不再是「你已經做了甚麼」,而是「你可能會做甚麼」。一旦某種行為模式、言論傾向或社交網絡被算法判定為「風險」,干預就可以在事件發生之前啟動。

這種轉變,意味著中國政治正在從以公開懲罰為核心的事後鎮壓,逐步轉向以數據建模和風險預警為核心的事前預防。暴力不再總是以可見的形式出現,而是被嵌入到結構之中:帳號被限制、行動被干擾、機會被提前關閉,卻往往找不到明確的責任主體。

結果是,控制變得更加穩定、更加低調,也更加難以對抗。個人面對的不再是某個具體的權力執行者,而是一整套持續運轉、不可協商、不可申訴的系統。正是在這種意義上,AI 並非簡單地「加強」了威權政治,而是為其提供了一種去人為因素、去摩擦、去中斷點的運行模式。

這正是 AI 對威權政治最關鍵、也最深遠的賦能。

三、AI 並沒有讓政治更「理性」 而是更「冷酷」

在官方敘事中,AI 常被描繪為一種可以減少人為偏見、提升治理效率和科學性的技術工具。通過數據分析和算法決策,權力似乎可以擺脫情緒化判斷與個體隨意性,轉而依賴「客觀」「中立」的系統運行。

但在現實的政治環境中,這種期待本身就是誤導性的。AI 並不會消除偏見,它只會繼承並放大既有的政治設定。算法並不自行決定甚麼是風險、甚麼是穩定、甚麼是正常秩序——這些標準早已由權力預先設定。AI 所做的,只是以更快的速度、更大的規模,把這些判斷執行到社會的每一個角落。

如果某些言論被定義為「風險」,AI 並不會進行價值判斷或比例衡量,而是更高效、更全面地將其識別、過濾和清除;如果某些群體被視為「重點人群」,算法就會通過長期的數據積累,將這種標籤固化下來,形成一種幾乎無法擺脫的系統記憶。與人的記憶不同,算法不會遺忘,也不會「網開一面」。

正因為如此,AI 帶來的並不是更溫和的治理,而是更冷酷的執行。人類在行使權力時,至少仍可能猶豫、妥協或選擇例外;而算法只會忠實地執行目標,並不斷優化執行效果。在缺乏權力制衡、司法獨立和言論自由的制度環境中,這種「理性化」的技術反而會讓壓制變得更加徹底、更加穩定。

因此,問題並不在於 AI 是否足夠先進,而在於它服務於怎樣的政治結構。在一個不允許權力被質疑的體系中,AI 不可能成為中立理性的工具,它只能成為既有政治偏見的加速器——讓不公更系統化,讓壓制更高效,也讓冷酷顯得更像一種「技術必然」。

四、AI 加固了以恐懼為基礎的統治結構

在 AI 介入之前,以恐懼為基礎的統治仍然存在明顯的成本與不確定性。高壓需要持續的人力投入,公開懲罰容易引發反感與反彈,過度鎮壓還可能暴露權力自身的焦慮。恐懼是一種有效但不穩定的治理資源,必須不斷被製造、展示和維持。

AI 的出現,徹底改變了這一結構。它不再依賴頻繁、可見的懲罰來製造震懾,而是通過持續監控、預測干預和不可見的限制,將恐懼轉化為一種日常化、內化的心理狀態。人們不再只是害怕「已經發生的懲罰」,而是長期生活在「可能隨時被注意到」的不確定之中。

算法並不需要公開宣示權力的存在。恰恰相反,它通過模糊邊界來放大恐懼:沒有清晰的紅線,沒有明確的違規告知,也沒有穩定的申訴機制。個體永遠無法確定,哪一次發言、哪一次轉發、哪一種聯繫,會被系統視為「異常」。這種不可預測性,正是恐懼得以長期運作的關鍵。

更重要的是,AI 讓恐懼脫離了具體的壓迫者。面對算法和系統,人們無法討價還價,也無法通過人際關係獲得豁免。權力不再需要被反覆展示其暴力能力,只需讓系統持續存在即可。久而久之,社會成員學會主動降低風險,避免表達、減少參與、提前退讓,恐懼由此完成自我複製。

在這種結構下,統治不再主要依靠恐懼的「爆發」,而依靠恐懼的「持續」。AI 並沒有製造新的統治邏輯,而是將一種本就存在的政治不信任加固為技術基礎設施,使其更加穩定、更低成本、也更難被瓦解。

五、AI 時代 中共政治面臨的真正風險

在 AI 時代,中共政治面臨的真正風險,並不在於技術是否失控,而在於權力可能徹底失去自我修正的能力。當治理越來越依賴算法,當判斷被系統化、自動化,政治決策就更容易被視為「技術結果」,而不再被當作需要承擔責任的權力選擇。錯誤不再表現為某個官員的失職,而是被掩蓋為模型偏差、數據異常或系統誤判,從而失去被追責、被糾正的出口。

更深層的風險在於,AI 會讓權力逐漸脫離現實社會的真實反饋。輿情被過濾,異議被提前消解,恐懼被內化為自我約束,最終呈現給決策層的,只剩下被算法「淨化」過的數據與表象穩定。在這樣的環境中,政治並非變得更理性,而是更容易陷入自我確認的閉環:系統不斷證明自身「有效」,卻無法識別潛在的結構性危機。

當一個政治體系既不需要傾聽真實聲音,也不需要為錯誤付出代價,技術的進步反而可能加速制度僵化。AI 本應是提升治理能力的工具,卻在缺乏制衡的條件下,演變為延緩問題暴露、推遲風險爆發的裝置。真正危險的不是系統出錯,而是系統永遠認為自己不會出錯。

六、AI 將監控邊界推向國境之外:留學生與海外異議者成為「數據延伸人口」

當這一套技術化治理邏輯向外延伸,其影響便不再侷限於國內社會。

AI 時代,中國政治監控的一個根本變化,是權力不再以國境為邊界。通過平台數據、社交媒體抓取、輿情分析和關係網絡建模,留學生與海外異議者被納入一種「遠程治理」體系之中。政治表達不再因為發生在海外而天然安全——相反,算法讓這些表達變得更可追蹤、更可標記、更可回溯。一次公開影片、一篇文章、一場校園演講,都會轉化為可被分析、關聯、存檔的政治數據。這種監控並不一定立即表現為拘捕或懲罰,而是以更隱蔽的方式出現:國內家屬被「關心」、個人被列入風險檔案、未來回國的不確定性被永久化。AI 在這裏扮演的角色,不是直接的鎮壓者,而是讓跨國威懾變得低成本、常態化和制度化。對留學生而言,最深層的壓力並非「已經發生了甚麼」,而是算法製造的那種持續存在的、無法確認邊界的恐懼——你永遠不知道,哪一次表達已經被系統記錄,哪一個節點會在未來被重新調用。

七、社交媒體審查:當平台算法成為「第一道政治關卡」

在 AI 加持下,社交媒體已成為中國言論審查最前線、也最有效的執行場。不同於傳統的事後刪帖,平台算法在內容發布的最初階段就完成了篩選:語義模型識別「風險表達」,推薦系統決定「是否可見」,傳播預測提前判斷「是否擴散」。結果是,大量內容並未被公開禁止,卻在發布瞬間被限流、摺疊、降權,悄無聲息地消失在訊息洪流中。審查不再以「紅線」存在,而是以「曝光概率」呈現——你能不能被看見,取決於系統對你內容的政治風險評分。

更關鍵的是,這種審查通過平台規則被市場化、去政治化。用戶面對的不是「國家禁止」,而是「平台規範」「社區守則」「系統異常」。責任被分散,權力被技術外判,政治判斷被包裝成商業決策。久而久之,創作者開始主動迎合算法偏好:迴避敏感議題、使用模糊隱喻、拆解觀點以規避觸發詞。社交媒體因此不再是公共討論的放大器,而變成了自我審查的訓練場。AI 並未減少審查成本,而是把審查變成一種默認運行的基礎設施——在這裏,沉默不是被強迫的結果,而是被算法「優化」出來的選擇。

八、政治異見人士的算法化監控:從「做了甚麼」到「你是誰」

在 AI 時代,政治異見人士不再僅因某一次具體行為而被關注,而是被轉化為一種長期、可計算、可繼承的風險身份。通過整合社交媒體記錄、通訊數據、出行軌跡、人際關係和歷史言論,算法可以構建出高度穩定的「異見者畫像」。一旦被系統標記,監控便不再依賴持續的人力投入,而是進入自動運行狀態:你的新帳號會被快速識別,你的表達會被優先審查,你的社交關係會被納入關聯分析。重要的並不是你是否再次「越線」,而是你是否仍然存在於系統的關注範圍內。

這種監控方式的殘酷之處在於,它幾乎不給「回到普通人狀態」的機會。政治異見不再是可以被澄清、被解釋、被遺忘的事件,而是一種被算法永久記憶的標籤。即使當事人保持沉默,系統仍然在後台持續運行,等待下一次觸發條件。AI 在這裏並未製造新的迫害邏輯,而是讓舊有的政治不信任獲得了無限續航能力:不需要頻繁打壓,卻能長期震懾;不需要公開懲罰,卻足以塑造恐懼。異見因此不只是被壓制,而是被結構性地「管理」,成為政治系統中一個永遠無法註銷的變量。

九、AI 會加速極權 還是加速分化?

一個繞不開的問題是:AI 最終會讓中共的極權統治更加穩固,還是反而加速其內部份化與失控?從短期看,答案似乎偏向前者。AI 顯著降低了治理成本,提高了監控效率,延緩了矛盾暴露的速度,使得原本依賴高壓維持的秩序看起來更加「平穩」「可控」。在這一階段,技術確實為極權提供了前所未有的工具支持。

但從中長期看,AI 也在悄然改變權力結構本身。高度依賴算法的統治,會逐步削弱基層官僚的自主判斷,使執行層對系統產生路徑依賴;同時,數據被層層過濾、風險被提前「消音」,決策層越來越難以接觸真實社會。這並非權力的集中,而是一種對技術中介的依賴性集中。當系統成為唯一可信的「現實來源」,權力反而可能失去對現實的直接感知。

更重要的是,AI 強化的並非社會整合能力,而是社會切割能力。人群被分類、評分、分層管理,不同群體之間的訊息、機會與命運被算法系統性區隔。這種治理方式可以壓制衝突,卻難以形成真正的政治認同。一旦技術系統出現偏差、資源分配失衡或突發危機,原本被算法壓平的差異,反而可能以更劇烈的方式集中爆發。

因此,AI 對極權的作用,並非單向的「穩定器」,而更像是一種延遲反饋、放大後果的結構性變量。它可以在一段時間內加固統治,但也可能在關鍵時刻放大失真、加速分化。技術越是被用於替代政治判斷,權力就越可能在失去現實感的同時,失去應對複雜社會的彈性。

結語:當算法成為權力的延伸 政治的代價也被系統化

無論 AI 最終是讓極權更穩固,還是在某個時刻加速分化,它都已經在改變中國政治的底層運行方式:權力越來越習慣於用數據替代傾聽,用預測替代解釋,用「系統判斷」替代責任承擔。技術在短期內確實能製造一種可控的幻覺——輿情被過濾,風險被提前壓制,矛盾被延後顯現,統治看起來更平穩、更高效。但真正的代價,是政治逐漸失去與社會真實互動的能力:真實聲音被降噪,真實衝突被隱藏,真實問題被推遲。

當治理被算法化,恐懼也會被基礎設施化。人們並非因為看見懲罰而沉默,而是因為無法確認邊界而自我收縮;不是因為被明確禁止,而是因為被系統性「不可見」。這種沉默表面上帶來穩定,實則削弱社會的修復機制——一個無法表達、無法糾錯、無法公開討論的體系,最終只能靠更強的控制去維持表面的秩序,而控制越強,反饋越弱,誤判越多。

因此,AI 不是未來的答案,而是現實的放大鏡:它放大一個政治體系對人的信任程度,也放大一個體系是否允許權力被質疑、被約束、被糾正。技術可以讓統治更高效,卻無法替代政治合法性;算法可以延緩危機,卻無法消除結構性風險。最終決定走向的,不是模型參數,而是權力是否願意承認:社會不是變量,公民不是數據,人也不應被簡化為「可管理的風險」——更不應被當作治理的原材料。#

本文僅代表作者本人觀點,並不一定反映《大紀元時報》立場。

-------------------

局勢持續演變

與您見證世界格局重塑

-------------------

🔔下載大紀元App 接收即時新聞通知:

🍎iOS:https://bit.ly/epochhkios

🤖Android:https://bit.ly/epochhkand

📰周末版實體報銷售點👇🏻

http://epochtimeshk.org/stores